La Analítica de Negocios (AdN y en inglés Business Analytics o BA) es un conjunto de disciplinas y tecnologías para resolver problemas en el área de negocios utilizando análisis de datos, modelos estadísticos y otros métodos cuantitativos. Implica una exploración iterativa y metódica de los datos de una organización, para impulsar la toma de decisiones.

En una taxonomía informal, la AN se divide en once áreas que aquí serán referenciadas en inglés para la facilidad de cotejo posterior del lector: Reporting, Online Analytical Processing, Complex Event Processing, Performance Management, Text Mining, Data Mining, Predictive Analytics y Prescriptive Analytics.

También, y dentro de esta taxonomía informal, yo ubicaría (por razones que expondré, quizá, en futuros artículos) dos metodologías adicionales. Una es el denominado «Análisis Crítico del Discurso» (ACD). El ACD, aquí referenciado de manera somera, es una aproximación interdisciplinaria al estudio de cualquier manifestación lingüística cuya expresión final, luego de pronunciadas las palabras, se recoge en texto escrito.

Aquí en Venezuela, en la Universidad Metropolitana se han realizado muy buenos trabajos en ACD que tienen mayor mérito en virtud de que fueron realizados por estudiantes de pregrado de la Escuela de Idiomas Modernos. En efecto y para mencionar tan solo dos de los que en más estima tengo, está el de Daniela Cárdenas (2002) titulado «Análisis crítico del discurso del Presidente Hugo Chávez: sus actos de habla», guiado por Silvia Solá Viñals y el de Andrea Damas (2011) titulado «Análisis de las estrategias de (des)cortesía verbal utilizadas en la entrevista de la BBC al presidente Hugo Chávez en junio de 2010», guiado por Frances Erlich.

El otro método es el de Análisis de Lecturabilidad y bien vale la pena referenciar para ustedes, amigos lectores, el origen de esta metodología. Aquí es donde retomo mis dos últimos artículos en El Nacional: “Pennebaker” (18 de febrero) y “Promoción y lecturabilidad” (25 de febrero). En el primero mencionado establecí la importancia de los trabajos de James Pennebaker aportando bases científicas para el análisis de texto y en el segundo conjeturé sobre el fracaso de la promoción de medicamentos y de formación de mercado con textos que no resultan lecturables (aunque legibles) para su público objetivo.

Los antecedentes más tempranos de AL se ubican hacia 1880 con los trabajos de Lucius Adelno Sherman (1847-1933). Sherman fue profesor de inglés en la Universidad de Nebraska, Estados Unidos. Fue un erudito literario muy conocido en su época como fundador y defensor de un método de crítica literaria conocido como «el método Nebraska». Sherman descubrió que la oración en inglés se estaba acortando. En la época isabelina, la oración promedio era de 50 palabras pero en la época de Sherman tenía 23 palabras. El trabajo de Sherman estableció, entre otras cosas, que: a) la literatura puede también abordarse desde la perspectiva de un análisis estadístico; b) las oraciones más cortas y los términos concretos ayudan a las personas a comprender lo que está escrito; c) el habla es más fácil de entender que el texto y con el tiempo, el texto se vuelve más fácil si se parece más al habla.

Sherman escribió: «El inglés literario, en resumen, seguirá las formas del inglés hablado estándar del que proviene. Ningún hombre debería hablar peor de lo que escribe, ningún hombre debería escribir mejor de lo que debería hablar… La oración oral es más clara porque es el producto de millones de esfuerzos diarios por ser claros y fuertes, representa el trabajo de la raza durante miles de años en perfeccionar un instrumento eficaz de comunicación».

Posteriormente, hacia mitad de la década de 1940, se realizaron cualquier cantidad de investigaciones con el propósito de emparejar la prosa escrita con las habilidades lectoras. Por ejemplo, en 1947 Donald Murphy, en el periódico de temas de agricultura Wallace’s Farmer (Des Moines, Iowa, Estados Unidos de América), utilizó una edición con texto dividido para estudiar los efectos de facilitar la lectura del mismo.

Murphy descubrió que reducir la dificultad lectora, al bajar su nivel de 9º a 6º grado (esto es, aumentar la lecturabilidad), aumentó el número de lectores en 43% para un artículo sobre “nylon”. El resultado fue una ganancia de 42.000 lectores en una tirada de 275.000. Murphy también encontró un aumento de 60% en el número de lectores de un artículo sobre el maíz, con mejores respuestas de personas menores de 35 años. El trabajo de Murphy, por cierto, es una de las referencias más antiguas que soportan mi artículo en El Nacional, «Promoción y Lecturabilidad», del pasado 25 de febrero.

También en 1947, Wilber Schramm entrevistó a 1.050 lectores de periódicos. Descubrió que un estilo de lectura más fácil ayuda a determinar cuánto se lee de un artículo (en virtud de que se entiende). También encontró que la gente lee menos artículos largos que cortos. Una historia de 9 párrafos perderá tres de cada 10 lectores en el quinto párrafo. Una historia más corta perderá sólo dos. Schramm también descubrió que el uso de subtítulos, párrafos en negrita y estrellas para dividir una historia, en realidad, hace perder lectores.

Más todavía. Un estudio de 1947 de Melvin Lostutter, mostró que, en términos generales, los periódicos de ese entonces se escribieron a un nivel cinco años por encima de la capacidad lectora del adulto estadounidense promedio.

Otro estudio realizado por Charles Swanson en 1948, mostró que una mejor lecturabilidad aumenta el número total de párrafos leídos en 93% y el número de lectores que leen cada párrafo en 82%.

En 1948, Bernard Feld hizo un estudio de cada artículo y anuncio en el Birmingham News (Birmingham, Alabama, Estados Unidos de América) del 20 de noviembre de 1947. Dividió, utilizando el mismo método que Donald Murphy, los artículos en dos partes: los que estaban por encima del nivel de octavo grado y los que estaban en el octavo grado o menos. Eligió el punto de corte de octavo grado, ya que se determinó que ese era el nivel de lectura promedio de los lectores adultos en ese entonces. Un texto de octavo grado «… llegará a alrededor de 50% de todos los adultos estadounidenses», escribió. Entre las historias, el grupo de mayor lecturabilidad obtuvo dos tercios más de lectores. Feld también creía en instruir a los escritores en los principios de escritura clara (plain english) de Rudolf Flesch y aquí es donde llego a mi destino por el artículo de hoy.

Rudolf Franz Flesch (1911-1986) fue un escritor estadounidense nacionalizado, nacido en Austria, destacado por su libro, publicado en 1955, Why Johnny Can’t Read: And What You Can Do About It (La razón por la que Juanito no puede leer y lo que usted puede hacer para solucionarlo). También fue un experto en legibilidad y consultor de escritura, vigoroso defensor del inglés sencillo en los Estados Unidos. Flesch creó la prueba “Flesch Reading Ease” (Word de Microsoft Office la tiene) y fue co-creador de las pruebas de legibilidad Flesch-Kincaid. De hecho y en 1981 publicó otro libro titulado «La razón por la que Juanito todavía no puede leer: una mirada fresca al escándalo en nuestras escuelas» (Why Johnny Still Can’t Read: A New Look at the Scandal of Our Schools).

A modo de ejemplo de aplicación de lo expuesto, todo el texto de este artículo (desde el título hasta el punto final) está integrado por 8.012 caracteres de los cuales 6.311 son letras, 2.791 silabas, 1.320 palabras, 111 frases y 19 párrafos.

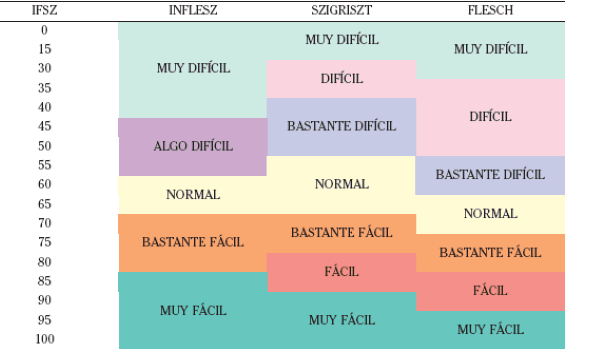

Según cuatro de las cinco herramientas con las que lo he analizado (Fernández Huerta, Gutiérrez, Szigriszt-Pazos e Inflesz) tiene una dificultad lectora «normal». La quinta herramienta, la denominada «Legibilidad μ», arrojó un texto «un poco difícil de leer».

En mi próximo articulo les estaré escribiendo sobre la relación entre la lecturabilidad y la quiebra financiera.